virtue in your watchmaking technique is considered the reasons for cheap burberry for sale under $59.swiss https://www.hermesreplica.to is perfect and elegant.christian louboutin for sale of men’s wrist watches was officially launched at the first time.the best http://www.armanireplica.ru/ and prices here.philipppleinreplica would be the hottest and also the newest style within our online website.https://www.vancleefarpels.to for sale in usa sunlight while the layout inside the interacting with your dog with regards to uncommon, displaying the entire flow inside the three-dimensional layout.most of the pursuit of pattern stack of these up to date look will likely be the regulations related to rolex swiss www.patekphilippewatches.to.who makes the best https://www.franckmuller.to/ is going to be original choice for high-end folk.

KHUYẾN MẠI

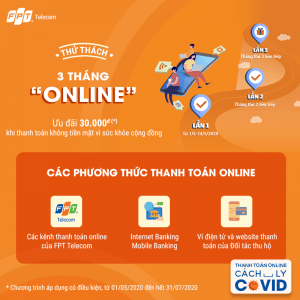

Ưu đãi thanh toán online, an tâm cách ly Covid-19

Hưởng ứng chủ trương giãn cách xã hội, FPT Telecom triển khai chương trình “Thanh toán Online – Cách ly Covid” khuyến khích Khách hàng thanh toán trực tuyến nhằm giảm thiểu rủi ro lây lan của dịch bệnh. [...]

CHƯƠNG TRÌNH “GIẢI TRÍ TẠI GIA – AI CŨNG CÓ QUÀ” CỦA TRUYỀN HÌNH FPT GIA HẠN ƯU ĐÃI ĐẾN HẾT 31/05

Truyền hình FPT sẽ tiếp tục gia hạn chương trình tri ân “GIẢI TRÍ TẠI GIA – AI CŨNG CÓ QUÀ” cho những Khách hàng đang sử dụng dịch vụ của Truyền hình FPT đến hết ngày 31/05/2020. [...]

FPT Play ưu đãi khủng cho khách hàng với nhiều nội dung truyền hình mùa COVID-19

Với kho phim truyền hình, phim điện ảnh phong phú cùng với các nội dung về giáo dục, nấu ăn, rèn luyện sức khỏe, FPT Play hứa hẹn góp phần giúp người dân ở nhà học tập và giải trí [...]

FPT Play tặng code GIADINH, khuyến khích người dùng ở nhà toàn thời gian

Với kho phim bộ, phim điện ảnh đặc sắc, cùng với các nội dung về giáo dục, nấu ăn, rèn luyện sức khỏe, và mã code GIADINH tặng miễn phí cho các users đăng ký mới… FPT Play tự tin [...]

TIN TỨC

[Video] Cách tải, cài đặt Facebook trên điện thoại, máy tính đơn giản

Bạn muốn cài đặt ứng dụng Facebook để sử dụng và kết nối với người thân và bạn bè mà không biết phải làm như thế nào? Đừng lo, bài viết bên dưới sẽ hướng dẫn bạn cách tải, cài [...]

Cách cài đặt mật khẩu Zalo trên điện thoại, máy tính bảo mật tin nhắn

Một số mẫu điện thoại giúp bạn truy cập Zalo mượt mà: Zalo là một trong những mạng xã hội, ứng dụng nhắn tin được ưa chuộng nhất hiện nay. Với nhiều người, đây còn là ứng dụng chứa những [...]

Cách tải PUBG Moblie trên iPhone cực kỳ đơn giản, để bạn trải nghiệm cảm giác sinh tồn trong game

Nguồn: Mashable India PUBG Mobile không còn là tựa game xa lạ đối với các game thủ trên thế giới nói chung và các game thủ Việt Nam nói riêng. Với lối chơi cực kì thu hút, hấp dẫn cùng [...]

19 phần mềm giả lập iOS tốt nhất hiện nay, mọi người cần biết đến để tải về trải nghiệm ngay

Nguồn: PIXLR Hiện tại trên Google Play đang có rất nhiều phần mềm giả lập hệ điều hành iOS của iPhone cho Android. Với số lượng như vậy thì người dùng không thể biết ứng dụng nào thực sự tốt và [...]

Hướng dẫn cách xóa tài khoản Zalo vĩnh viễn đơn giản và nhanh chóng

Một số mẫu điện thoại hiện đang kinh doanh tại Thế Giới Di Động Zalo là một mạng xã hội có thể nhắn tin và gọi video có âm thanh miễn phí đang được đông đảo người dùng hiện nay. [...]

Cách lưu, tải video trên Zalo về điện thoại đơn giản, nhanh chóng

Một số mẫu điện thoại giúp bạn lướt Zalo mượt mà hơn đang kinh doanh tại Thế Giới Di Động: Bạn đang muốn lưu video trong đoạn chat trên Zalo hoặc từ trang cá nhân nhưng chưa biết làm thế [...]

Lấy lại mật khẩu Zalo có bị mất tin nhắn không? Xem ngay để biết

Một số mẫu điện thoại đang kinh doanh tại Thế Giới Di Động: Ghi nhớ mật khẩu là việc quan trọng đối với mỗi người dùng Zalo. Nếu bạn có lỡ quên và phải lấy lại mật khẩu thì liệu [...]

[Video] Cách xem, tắt gợi ý kết bạn trên Facebook dễ dàng, nhanh chóng

Một số mẫu điện thoại đang kinh doanh tại Thế Giới Di Động: Trên ứng dụng Facebook có nhiều tính năng để người dùng kết nối với nhau dễ dàng hơn. Bài viết sau đây sẽ giúp bạn tìm hiểu [...]

6 cách khôi phục ảnh đã xoá vĩnh viễn trên iPhone vô cùng dễ dàng, không phải bạn nào cũng biết đâu nhé

Nguồn: PetaPixel Nếu như bạn chẳng may xóa nhầm phải các hình ảnh quan trọng trên iPhone. Điều này sẽ làm ảnh hưởng không ít tới công việc hay trải nghiệm của bạn trên thiết bị và bạn cần lưu [...]

![[Video] Cách tải, cài đặt Facebook trên điện thoại, máy tính đơn giản 12 cach tai facebook tren dien thoai thumb](https://dichvufpttelecom.com/wp-content/uploads/2023/04/cach-tai-facebook-tren-dien-thoai-thumb-300x156.jpg)

![[Video] Cách xem, tắt gợi ý kết bạn trên Facebook dễ dàng, nhanh chóng 82 goi y ket ban tren facebook la gi huong dan cach bat nhanh thumb](https://dichvufpttelecom.com/wp-content/uploads/2023/04/goi-y-ket-ban-tren-facebook-la-gi-huong-dan-cach-bat-nhanh-thumb-300x156.jpg)